[Azure] Databricks-CLI 安裝使用

本篇想要講述如何利用 Databricks 提供的 CLI 來針對需求下指令! 透過 Databricks-CLI 的幫助許多自動化的流程可以比較容易被實現,本篇參考的是 Azure Databricks 的官方安裝指南。

安裝 Databricks CLI:

首先利用 pip3 安裝 Databricks CLI

pip3 install databricks-cli

pip3 list

Package Version

---------------- ----------

databricks-cli 0.10.0設定認證資料:

接下來設定連線的認證資訊,設定好的資訊會被存在 ~/.databrickscfg 裡面。關於 Token 產生的連結可以參考,主要 Token 是由 Databricks 裡面產生的!

databricks configure --token

Databricks Host (should begin with https://):

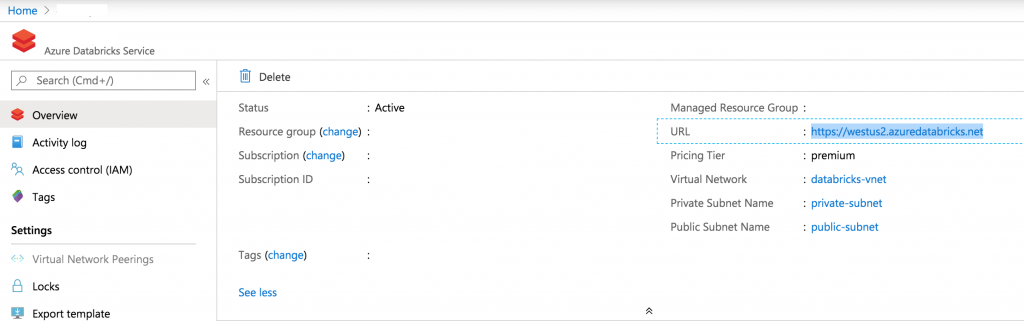

Token:Host 的資訊可以從 Azure Databricks Resource 頁面的 URL 取得:

執行/管理 Jobs:

這邊官網給了兩個例子分別從 Unix 與 Windows 出發去執行 Databricks Jobs,Unix 的執行方法:

databricks jobs run-now --job-id 9 --jar-params '["20180505", "alantest"]'Windows 的執行方法:

databricks jobs run-now --job-id 9 --jar-params "[\"20180505\", \"alantest\"]"如果是透過一個已經寫好的 json 檔案來行的話可以參考以下:

databricks jobs create --json-file example.json其他可以使用 databricks-CLI 執行的指令列在以下參考用:

Commands:

create Creates a job.

delete Deletes the specified job.

get Describes the metadata for a job.

list Lists the jobs in the Databricks Job Service.

reset Resets (edits) the definition of a job.

run-now Runs a job with optional per-run parameters.連結 DBFS:

使用 DBFS 其實跟一般 hdfs 或是 linux FileSystem 是非常類似的指令,只不過如果是在 dbfs 端的檔案需要加註 dbfs://

databricks fs ls dbfs:/dev/datalake以下是 databricks-CLI 可以使用的 fs 指令:

Commands:

cat Show the contents of a file.

configure Configures host and authentication info for the CLI.

cp Copy files to and from DBFS.

ls List files in DBFS.

mkdirs Make directories in DBFS.

mv Moves a file between two DBFS paths.

rm Remove files from dbfs.

One thought on “[Azure] Databricks-CLI 安裝使用”